AI: come viene utilizzata per ingannarti

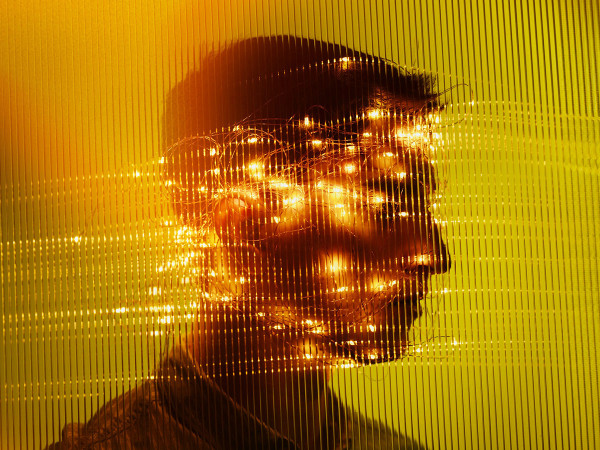

Il Presidente russo Vladimir Putin in manette, Papa Francesco che indossa un improbabile piumino bianco da trapper e l’ex Presidente degli Stati Uniti Donald Trump intento a pregare sono solo alcune delle più famose immagini fake diffuse online nel corso dell’ultimo anno. Immagini e video talmente realistici da sembrare veri. Tuttavia, se fino a ora riconoscerle poteva essere abbastanza semplice - pensiamo alle dita delle mani in più, come nella stessa “foto” di Trump, oppure alla presenza di errori concettuali o numerici- oggi l’intelligenza artificiale e i suoi creatori sono sempre più precisi e rendono estremamente difficile stabilire la veridicità di un’immagine.

Il Primo Ministro britannico Rishi Sunak è una delle ultime vittime dell’AI. In un video diffuso sulle principali piattaforme social un giornalista espone una breaking news: il Primo Ministro avrebbe per mesi ottenuto guadagni stratosferici da un progetto pensato per i cittadini al fine di contrastare l’erosione dei risparmi dovuta all’inflazione. Ed eccolo lì, subito dopo, Sunak che presenta questa nuova applicazione elaborata dal magnate Elon Musk promettendo agli utenti, con un investimento di sole 200 sterline, un guadagno di più di 22 mila sterline in un mese.

Un annuncio costato ai suoi creatori solo tra l’8 dicembre 2023 e l’8 gennaio 2024 quasi 13 mila sterline, secondo il rapporto di Ferimore Harper Comunications, e che avrebbe raggiunto oltre 400.000 persone con circa 143 annunci. Dietro a tutti questi video sembrerebbe esserci Quantum AI una piattaforma truffa che spinge gli utenti a investire non permettendogli poi più di ritirarsi e riacquisire indietro il proprio denaro.

Se da anni si combatte contro chi su Internet aggancia i soggetti più disparati facendo leva sulle fragilità o sui momenti di difficoltà delle persone con scopi illeciti, l’AI pone la questione su un nuovo piano. L’introduzione di immagini e video di personaggi appartenenti al mondo politico, imprenditoriale o dello spettacolo apre, difatti, il dibattito sulla diffamazione, oltre a rendere le truffe sempre più credibili e difficili da riconoscere.

Ma come possiamo mettere un freno a tutto questo? È proprio ciò su cui si interrogano i ricercatori dell’AI e le principali aziende del settore.

Microsoft e Intel hanno presentato e continuano a lavorare alla realizzazione di software in grado di riconoscere immagini, video e testi realizzati artificialmente. Al tempo stesso gli sviluppatori dell’AI studiano un modo per garantire una riconoscibilità al 100% dei propri prodotti. Eppure, un sistema completamente affidabile non è ancora stato trovato. Uno studio elaborato da Zeyu Lu, scienziato informatico dell’Università Jiao Tong di Shangai, evidenzia come anche il programma più performante in questo campo verrebbe ingannato nel 13% dei casi analizzati, indicando come “vere” immagini in realtà realizzate tramite l’AI.

Lo scorso dicembre a New Orleans si è tenuta la conferenza sui sistemi neurali dell’elaborazione dell’informazione, NeurIPS, dove sono state presentate diverse opzioni per garantire l’identificazione delle immagini digitali. Ricercatori e università hanno elaborato software e sistemi per applicare, proprio come avviene con la carta, una filigrana con l’obiettivo di tracciare tutto ciò che viene creato dall’AI.

Un primo sistema per l’analisi di testi si basa sulla creazione di blocchi di parole che vengono divise in due gruppi: uno “verde” per quelle parole conosciute dal sistema e un gruppo “rosso” per tutte le altre.

A questo punto il software, in base a calcoli statistici e di probabilità, confronta i due blocchi e ne analizza la veridicità. Un sistema che, tuttavia, sembrerebbe essere maggiormente efficace con testi lunghi ed elaborati.

Un altro progetto prevede l’applicazione della filigrana tramite dei pixel non visibili a occhio nudo, ma intercettabili dalle macchine. Anche in questo caso però i falsificatori di immagini potrebbero riuscire a bypassare il software semplicemente lavorando sull’immagine, per esempio ruotandola o sfocandola.

Ancora, nel modello nominato Tree-Ring, la tela digitale verrebbe riempita prima da un rumore e poi dall’immagine permettendo così di inserire nel rumore la filigrana distintiva.

Secondo un team di esperti dell’Università di Harvard, anche questo modello potrebbe essere superato aggiungendo un nuovo rumore all’immagine.

Nonostante tutto, dunque, una risposta definitiva all’utilizzo improprio di immagini e parole non è stata ancora trovata. Le immagini digitali diventano sempre più accurate rendendo il lavoro per truffatori e falsificatori ancora più semplice. Fondamentale è prestare attenzione e diversificare la fonte delle notizie per evitare di incappare in malintenzionati pronti a trarci in inganno.