Tesla: la guida automatica è davvero più sicura?

- Indice dei contenuti

- Le funzionalità di Tesla

- Il pilota automatico e altre indagini su Tesla

L’autopilot – il sistema di assistenza alla guida di Tesla – è davvero sicuro? Secondo i dati, non sembrerebbe. Dal 2019 a oggi, infatti, negli Stati Uniti si sono registrati 736 incidenti stradali e 17 vittime.

Sono i dati emersi da un’inchiesta condotta dal Washington Post: il numero di questi incidenti, nel corso degli ultimi 4 anni, è aumentato sensibilmente, riflettendo i pericoli associati al sempre più diffuso utilizzo della tecnologia di assistenza alla guida di Tesla e alla crescente presenza di auto sulle strade degli Usa.

A subire un aumento, purtroppo, è stato anche il numero di vittime e feriti gravi associati all’autopilota: nel giugno del 2022 – quindi soltanto un anno fa – il numero di vittime legate a questa tecnologia erano soltanto 3. I dati più recenti includono 17 incidenti mortali e 5 feriti gravi.

Un’emblematica vicenda, in questo scenario, è l’incidente ad Halifax, Carolina del Nord, che ha coinvolto Tillman Mitchell, 17 anni, investito da una Tesla in modalità autopilot appena sceso dallo scuolabus, regolarmente in sosta con segnale di stop e luci rosse lampeggianti. Fortunatamente, Mitchell è sopravvissuto, nonostante le brutte ferite e le conseguenze che ancora oggi sta affrontando.

Elon Musk, l’Amministratore delegato di Tesla, afferma che le auto guidate in modalità automatica sono più sicure di quelle pilotate esclusivamente da conducenti umani, citando alcuni dati che confrontano il numero di incidenti secondo le due modalità di guida. La casa automobilistica ha sviluppato il suo sistema cercando di implementare le sue funzionalità considerando più variabili presenti in strada, sostenendo che, grazie alla tecnologia, il futuro potrà essere più sicuro e privo di incidenti.

Ma, sebbene non sia possibile calcolare quanti incidenti sono stati effettivamente evitati grazie alla tecnologia dell’autopilot, i dati rilevati su quelli accaduti sembrano chiari. Secondo quanto rilevato dall’indagine, inoltre, alcune delle decisioni prese da Musk, come per esempio ampliare quasi esageratamente le funzionalità disponibili e privare i veicoli dei sensori radar, sembrano aver contribuito all’aumento di incidenti.

La National Highway Traffic Safety Administration ha chiarito però che la responsabilità non è attribuibile necessariamente alla tecnologia in sé. Veronica Morales ha commentato spiegando che «tutti i sistemi avanzati di assistenza alla guida richiedono che il guidatore umano abbia il controllo e sia pienamente coinvolto nell’attività di guida in ogni momento. Di conseguenza, tutte le leggi statali ritengono che il conducente umano sia responsabile del funzionamento dei propri veicoli».

Musk lo scorso anno difendeva la sua posizione spiegando che il vantaggio supera il danno: «Se credi che l’aggiunta di autonomia riduca lesioni e morte, hai l’obbligo morale di implementarla, anche se verrai citato in giudizio e incolpato da molte persone. Perché le persone a cui hai salvato la vita non sanno che le loro vite sono state salvate».

Una ex consulente della Nhtsa, Missy Cummings, si dichiara preoccupata per l’aumento degli incidenti: «Tesla sta registrando incidenti più gravi e fatali rispetto alle persone rispetto a un normale set di dati. Una probabile causa – spiega in merito all’inchiesta – è l’ampliamento delle funzionalità nell’ultimo anno, che porta l’assistenza alla guida nelle strade cittadine e residenziali. Il fatto è che tutti possono averlo: è quindi ragionevole aspettarsi che possa portare a un aumento di incidenti? Direi di sì».

Le funzionalità di Tesla

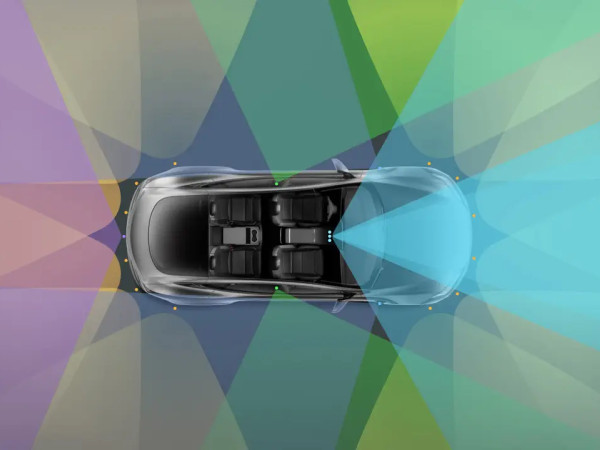

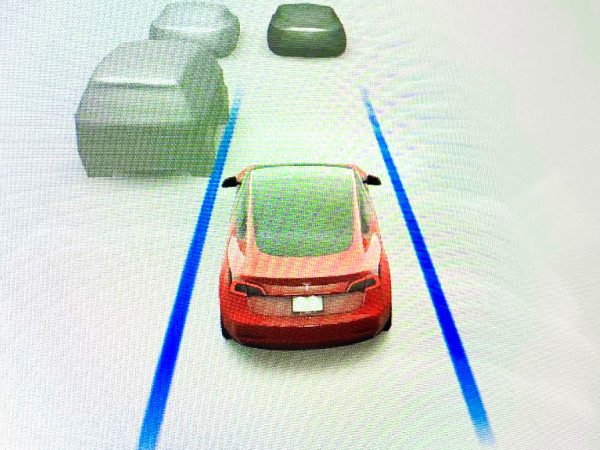

L’autopilot di Tesla comprende una serie di funzioni che, introdotte nel 2014, consentono alle auto di manovrarsi da sola dall’ingresso fino all’uscita della rampa dell’autostrada mantenendo la velocità e la distanza dietro gli altri veicoli seguendo le linee di corsia. Ed è una funzione standard dei suoi veicoli.

Il full self-driving, invece, è una funzionalità sperimentale che i clienti devono acquistare, e consente la guida automatica da un punto A fino un punto B, seguendo le indicazioni passo dopo passo lungo un percorso, fermandosi a segnali di stop e semafori, effettuando svolte e cambi di corsia per rispondere ai pericoli lungo il percorso. Con entrambi i sistemi, però, è previsto che i conducenti monitorino la strada e intervengano quando necessario.

Già a febbraio, però, l’azienda di Musk aveva emesso un richiamo di oltre 360.000 veicoli dotati di questa funzionalità, per il timore che il software spingesse i suoi veicoli a disobbedire a semafori, segnali di stop e limiti di velocità. E, come affermano i documenti pubblicati dall’Nhtsa, la violazione delle leggi sul traffico potrebbe aumentare il rischio di collisione se il conducente non interviene.

L’aumento degli incidenti, dunque, sembra coincidere con l’implementazione aggressiva della funzionalità full self-driving, passata in poco più di 12 mesi da 12.000 utenti a quasi 400.000. E, non a caso, quasi i due terzi di tutti gli incidenti di assistenza alla guida che Tesla ha segnalato a Nhtsa si sono verificati proprio nell’ultimo anno.

Philip Koopman, docente della Carnegie Mellon University, che per 25 anni si è occupato di ricerche sulla sicurezza dei veicoli autonomi, ha dichiarato che la prevalenza di Tesla nei dati solleva questioni importanti: «Un numero significativamente più alto è certamente motivo di preoccupazione. Dobbiamo capire se è dovuto a incidenti effettivamente peggiori o se c’è qualche fattore come un numero notevolmente maggiore di miglia percorse con il pilota automatico».

Il pilota automatico e altre indagini su Tesla

Dopo la clamorosa decisione di eliminare i sensori radar delle nuove auto e disabilitarli dai veicoli già in strada, lo stesso Musk aveva precisato che solo la presenza di un radar ad altissima risoluzione avrebbe fatto un’effettiva differenza. Tuttavia, la società ha recentemente adottato misure per reintrodurre i sensori.

Il pilota automatico, in gran parte basato su un sistema autostradale, meno complesso rispetto alla gamma di situazione che si vivono tipicamente nelle strade urbane. E quale dei sistemi fosse in uso negli incidenti mortali non è dato sapersi, perché Tesla ha voluto mantenere l’informazione riservata.

Sia il pilota automatico che la guida completamente autonoma sono oggetto di studio negli ultimi anni: Pete Buttigieg, il Segretario ai Trasporti, ha affermato che, per come la vede lui, “pilota automatico” non è un nome appropriato, perché è sempre necessario, da parte del guidatore, avere gli occhi su strada e mani sul volante.

Nhtsa ha aperto diverse indagini sugli incidenti Tesla e altri problemi con il suo software di assistenza alla guida. Per esempio, uno di questi riguarda la “frenata fantasma”, un fenomeno per cui i veicoli rallentano bruscamente per pericoli immaginari.

Lo scorso anno, infatti, una Tesla Model S, avrebbe utilizzato la funzione di assistenza alla guida, e improvvisamente avrebbe frenato nel traffico, provocando un tamponamento con otto veicoli e il ferimento di nove persone, tra cui un bambino di 2 anni.

In altri reclami depositati presso l’autorità competente, i proprietari affermano che le auto hanno frenato di colpo quando hanno incrociato semirimorchi provenienti dalle corsie opposte. Nel complesso, Nhtsa ha ricevuto più di una dozzina di segnalazioni di Tesla che si sono schiantate contro veicoli di emergenza parcheggiati.

Colpa della tecnologia? Disattenzione umana? Una cosa resta certa: quando sei alla guida, non distrarti. Anche se hai il pilota automatico inserito.