Possiamo contrastare l’aumento dei messaggi falsi dell’AI?

Immersi nella disinformazione. Incapaci di discernere il vero e il falso. Disinteressati persino a distinguere le notizie importanti e documentate da quelle irrilevanti e prive di fondamento. È un problema dei cittadini del futuro che faranno i conti con le applicazioni più vigliacche dell’ingellizenza artificiale?

La preoccupazione è fondata. Yoshua Bengio, uno dei pionieri dell’intelligenza artificiale che lavora alla Universitè de Montréal, è convinto che l’automazione cognitiva possa moltiplicare la disinformazione. Questa tecnologia produce testi - o immagini - senza alcun incentivo a dire il vero, ma con l’obiettivo di estrarre statisticamente il verosimile da una grande quantità di dati.

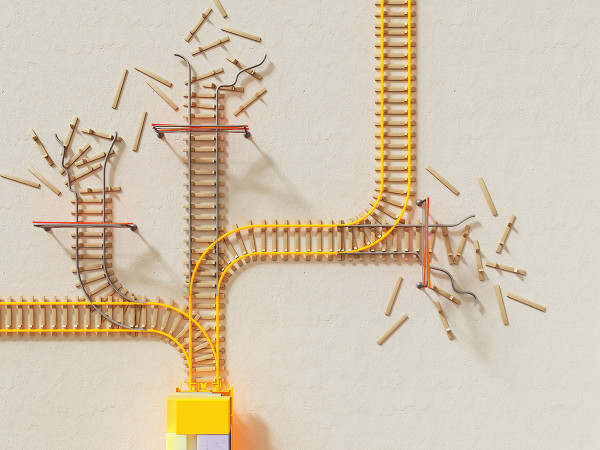

Si può usare per produrre industrialmente post di disinformazione per i social network. Si può usare per generare newsletter e messaggi di mail perfettamente credibili con le quali modernizzare il phishing e le altre truffe via posta elettronica. Si può usare per produrre foto false di personaggi veri. E tutto questo può raggiungere una quantità tale da sommergere i post, i messaggi e le immagini che documentano realmente su quello che accade.

Bisogna ammettere, peraltro, che i cittadini del mondo devono fronteggiare da tempo una quantità enorme di falsità. L’intelligenza artificiale generativa può industrializzare pratiche che erano già ampiamente adottate per manipolare l’opinione pubblica. Ma già gli algoritmi di raccomandazione dei social network fanno da tempo il loro mestiere nel diffondere messaggi intriganti e raccogliere attenzione da rivendere sul mercato pubblicitario, senza alcun incentivo a privilegiare le informazioni ben documentate e molto spesso trovandosi, di fatto a rilanciare messaggi falsi.

Più in generale, leggendo le notizie, sembra da decenni di vivere in una lunghissima commedia degli inganni. L’Advertising Standards Authority britannica ha condannato la pubblicità di alcune compagnie petrolifere in quanto non rispecchia la realtà, facendo credere che l’impegno di quelle compagnie per la sostenibilità sia proporzionato all’inquinamento che producono, il che purtroppo non è vero.

Intanto, la European Banking Authority ha fatto sapere che i casi di greenwashing tra le banche dell’Unione europea sono sempre più frequenti e rilevanti. Insomma, gli incentivi a “abbellire” la realtà sono ovunque: tra i giovani che pubblicano foto di sé stessi truccate da filtri che migliorano il loro aspetto fisico e tra i potenti che sperano di coltivare la propria popolarità. E l’americana Federal Trade Commission ha censito 92.000 truffe online basate su ingannevoli informazioni sul lavoro e possibili assunzioni. La disinformazione colpisce duro nel mondo della sanità, della finanza e, naturalmente, della politica. E non è certo soltanto opera di criminali e potenze straniere autoritarie in conflitto contro le democrazie: non si può negare che la propaganda ingannevole sia uno strumento usato spudoratamente da qualsiasi grande potere.

Ma l’intelligenza artificiale è un ulteriore acceleratore del fenomeno. Secondo Rand, i “deep fake” possono trarre in inganno anche i lettori più critici per la loro accurata verosimiglianza.

Naturalmente ci credono di più coloro che già sono immersi in narrative coerenti: storie di cospirazione, grandi quadri interpretativi sulla legittimità delle elezioni americane o sulla credibilità dei vaccini, e così via.

Noémi Bontridder e Yves Poullet hanno raccolto in un paper pubblicato da Cambridge University Press le ragioni che possono condurre a pensare che l’intelligenza artificiale possa aumentare la disinformazione, anche se concludono dicendo che alla radice ci sono i modelli di business. E in effetti Marshall W. Van Alstyne, della Boston University, propone uno schema di ragionamento per affrontare il problema: considerare la disinformazione non tanto per la sua qualità di falsa informazione, ma per i danni che causa e ritenere responsabili di quei danni tutti coloro che la producono e diffondono.

In questo modo il pagamento dei danni potrebbe diventare un disincentivo a fare disinformazione e frenarne la produzione e diffusione. E l’Ocse ha lanciato una piattaforma di scambio di informazioni tra governi per coordinare gli sforzi orientati al contrasto della disinformazione, ricordando che meno di un quarto dei cittadini ha fiducia nelle notizie e più della metà si sente ingannata da giornalisti, politici e governi.

Se è già così, l’automazione cognitiva potrebbe dunque peggiorare la situazione. E in uno scenario non irrealistico, la quantità di falsità sarà tale da diventare un’esperienza quotidiana per quasi tutti. A quel punto si dovrà lavorare anche sulla protezione e valorizzazione delle informazioni documentate seriamente.

La Commissione europea intende imporre un bollino che avverte i cittadini che un certo prodotto informativo è stato generato dall’intelligenza artificiale. Ma può valere anche la pena di aggiungere un bollino anche ai prodotti documentati degli umani, magari contenente la sua storia produttiva. Come nell’alimentazione si potrebbero avere i messaggi che si segnalano per essere stati prodotti secondo la ricetta - il metodo - della scienza o del più tradizionale giornalismo “d.o.c.”.

Oppure, in quanto prodotto umano, come suggeriva un epistemologo di nome Giuseppe Conte su LinkedIn, il bollino di qualità potrebbe essere “bio”.